Generative AI im neuen Azure AI Studio

Generative AI-Funktionen in der Praxis

In zwei vorangegangen Artikeln habe ich dir gezeigt, was man grundsätzlich unter generativer AI versteht, wie du generative AI in Form von Copiloten mit und ohne Microsoft-Tools nutzen kannst und wie du das neue Azure AI Studio einrichtest. In diesem Beitrag zeige ich dir Nutzung generativer AI im AI Studio. Die vermittelten Kenntnisse sind wertvoll zur Zertifizierung AI 102 (Azure AI Engineer Associate).

Passende Schulungen

AI-102 – Designing and Implementing a Microsoft Azure AI Solution (AI-102T00)

AI-900 – Microsoft Azure AI Fundamentals (AI-900T00)

AI-900 – Microsoft Azure AI Fundamentals (AI-900T00): Einführung in künstliche Intelligenz (AI) und Grundlagen von AI in Azure

Für die Nutzung generativer AI im Azure kannst du entweder …

- eine Azure OpenAI -Ressource erzeugen und das Azure OpenAI-Studio verwenden

- oder eine Ressource vom Typ „Azure OpenAI“, „Azure AI Service“, bzw. „Azure AI services multi-service-account“ und das Azure AI-Studio verwenden, je nach Kontext auch „Azure KI-Studio“ genannt.

Dieser Artikel konzentriert sich auf letztere. Wie im vorangegangenen Artikel erläutert kannst dazu …

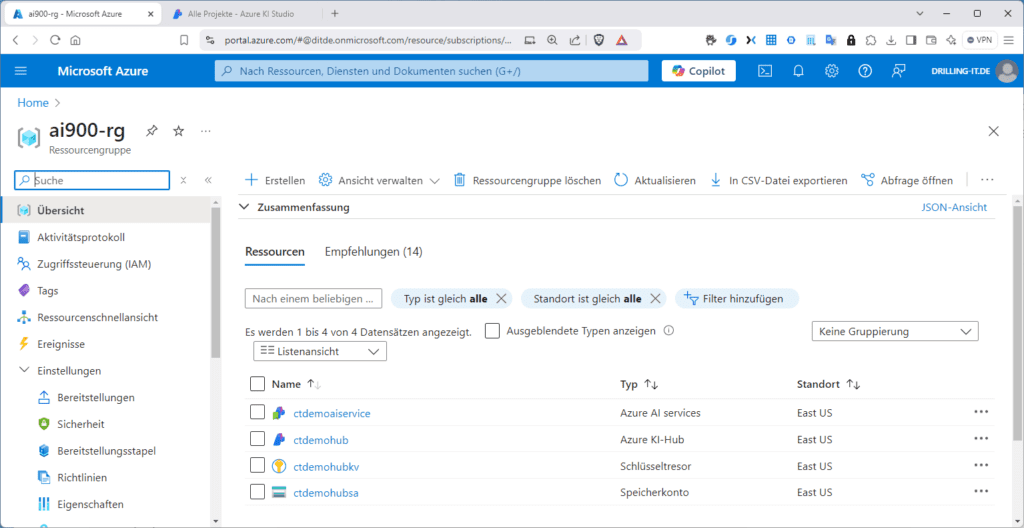

- … entweder mit dem Azure AI Studio starten und dort ein neues Projekt ablegen. Dies zieht das Aufsetzen eines Hubs und das Anlegen einer Ressource vom Typ „Azure AI services“ sowie eines verknüpften Speicherkontos und eines Schlüsseltresors nach sich.

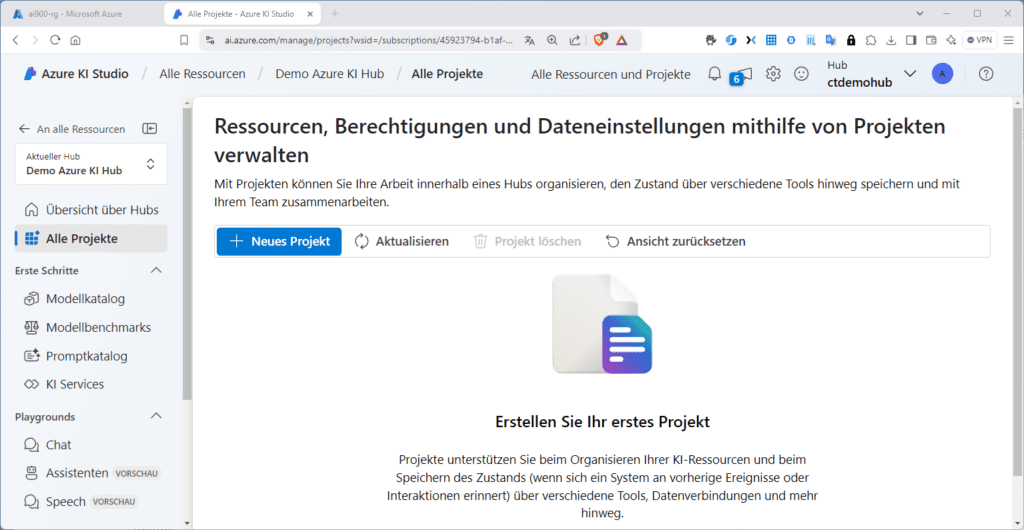

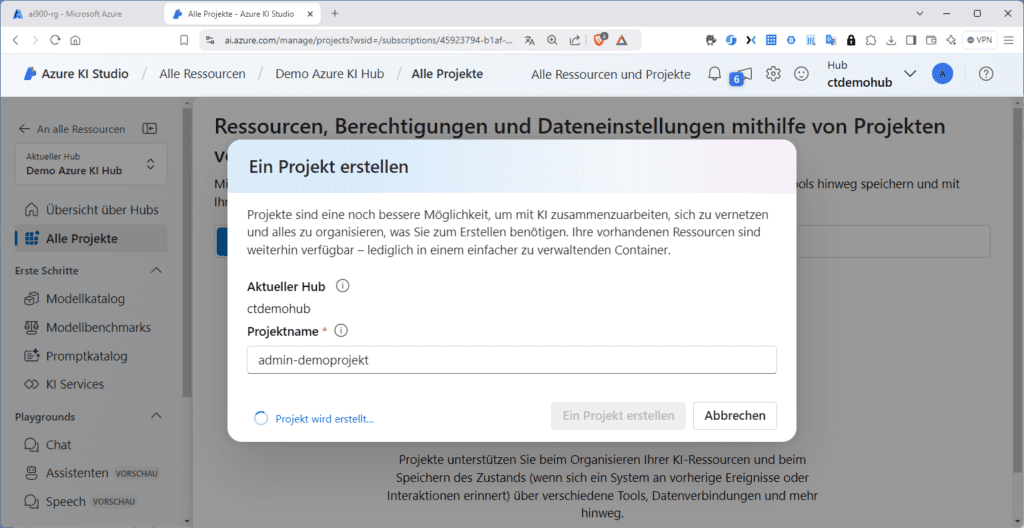

… oder im Azure-Portal nach einer Ressource vom Typ „Azure KI Studio“ suchen und dort neuen AI-Hub erstellen („New Azure AI hub“). Danach wechselst du im AI Studio zu deinem Hub, dort zu „Alle Projekte“ und erstellst mit dem gleichnamigen Button ein „Neues Projekt“.

So oder so kannst du dich danach im https://ai.azure.com AI Studio mit dem zugehörigen Organisationskonto anmelden und loslegen.

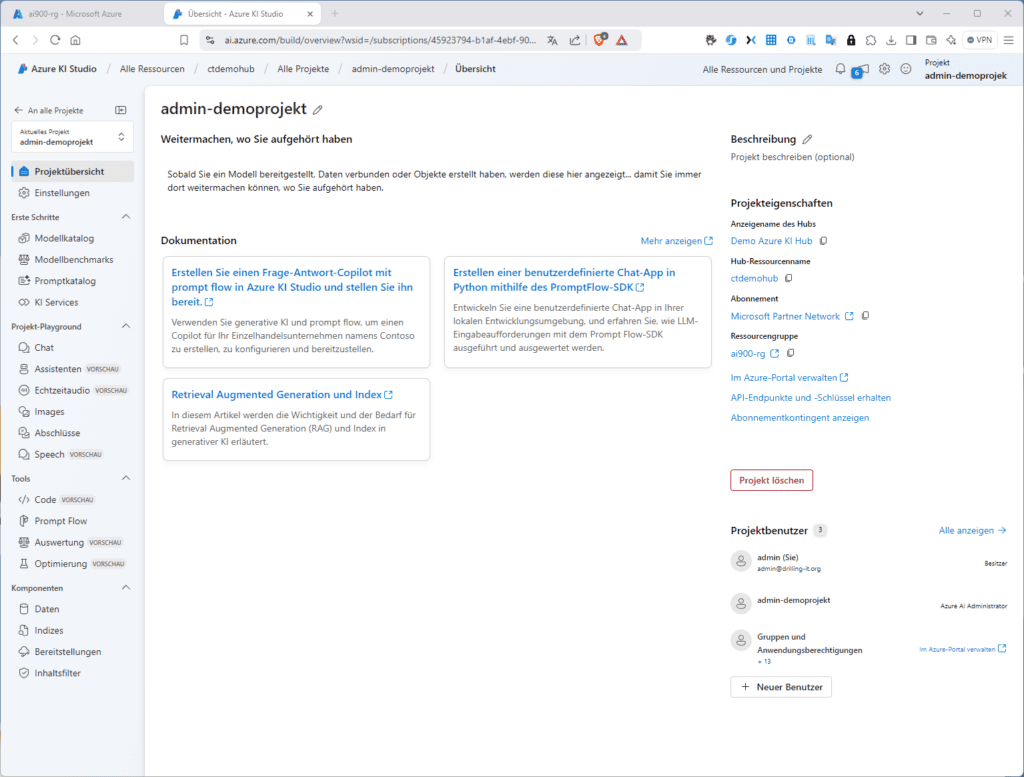

Deine Projekt-Übersicht sieht nun so aus:

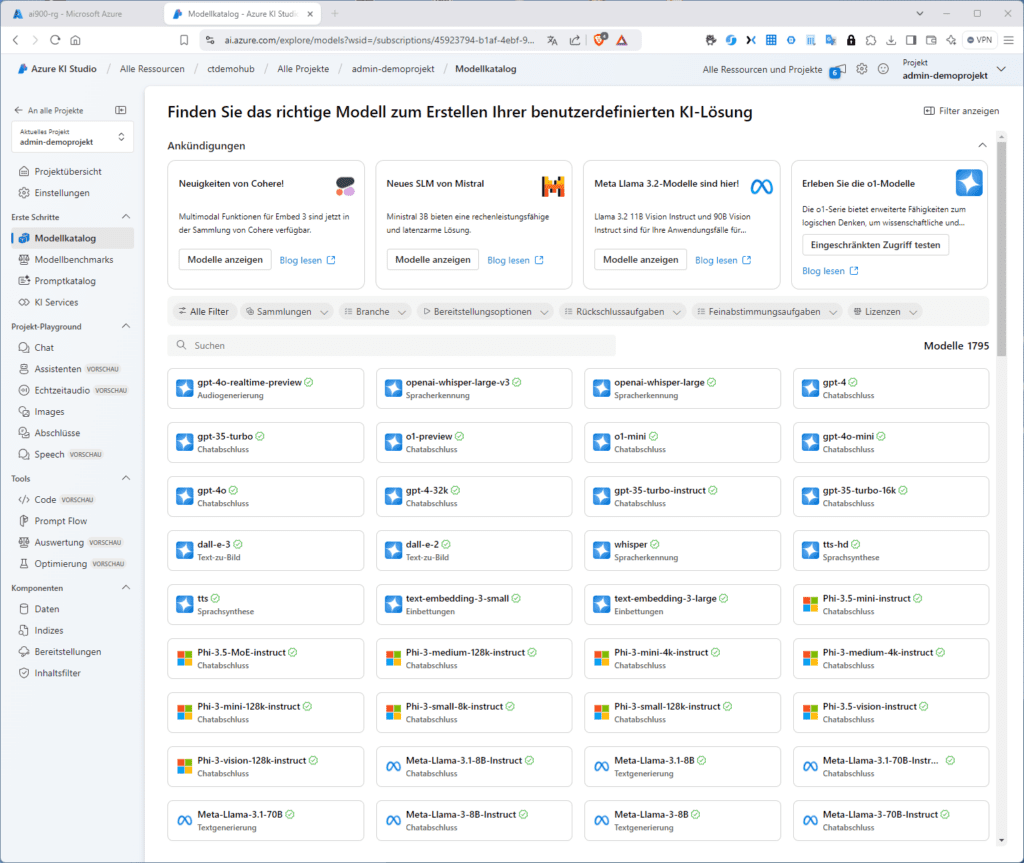

Da das neue AI Studio sämtliche in Azure verfügbaren KI-Services adressiert, wir uns aber hier mit generativer AI befassen wollen, bräuchtest du eigentlich eine Azure-Ressource von Typ „Azure OpenAI“. Allerdings wurde beim Anlegen des Hubs bereits eine Azure-Ressource vom Typ „Azure AI services“ erstellt, auf deren Basis du ebenfalls OpenAI-Funktionen, also generative AI nutzen kannst. Du kannst dir jetzt z. B. unter „Modellkatalog“ die verfügbaren Modelle ansehen. Du erkennst beim jeweiligen Modell auch den vorgesehenen Verwendungszweck, wie z. B. „Spracherkennung“, „Chat-Abschls“, „Sprachsynthese“ oder „Text-zu-Bild“.

Dieser Modellkatalog in Azure AI Studio fungiert als dein Hub zur Bereitstellung und Erkundung einer Vielzahl von Modellen, die als Basis für deine generativen KI-Anwendungen dienen könnten. In Vergleich dazu stünde dir im Chat-Bot des Microsoft Copiloten nur „gpt-4“ zur Verfügung. Würdest du über „gtp-3.5“ hinausgehende Modelle beim Partner und Konkurrenten OpenAI verwenden wollen, müsstest du bei OpenAI ein Konto erstellen und einen kostenpflichtigen Plan erwerben.

Im Azure AI-Studio kannst du jedes verfügbare Modell verwenden. Die entstehenden Kosten werden dann über dein Azure-Abonnement nutzungsbasiert abgerechnet. Preis-Details zu den OpenAI-Features findest du auf der zugehörigen https://azure.microsoft.com/en-us/pricing/details/cognitive-services/openai-service/#pricing Preisseite von Microsoft. Den „Tarif“ siehst du in der zugehörigen Azure-Ressource vom Typ „Azure AI services“. Hinzu kommen allerdings (je nach Modell) die Kosten für die Rechenleistung, die zur Bereitstellung und Ausführung der Modelle erforderlich ist. Manche Modelle erlauben z. B. auch einen serverlosen Betrieb.

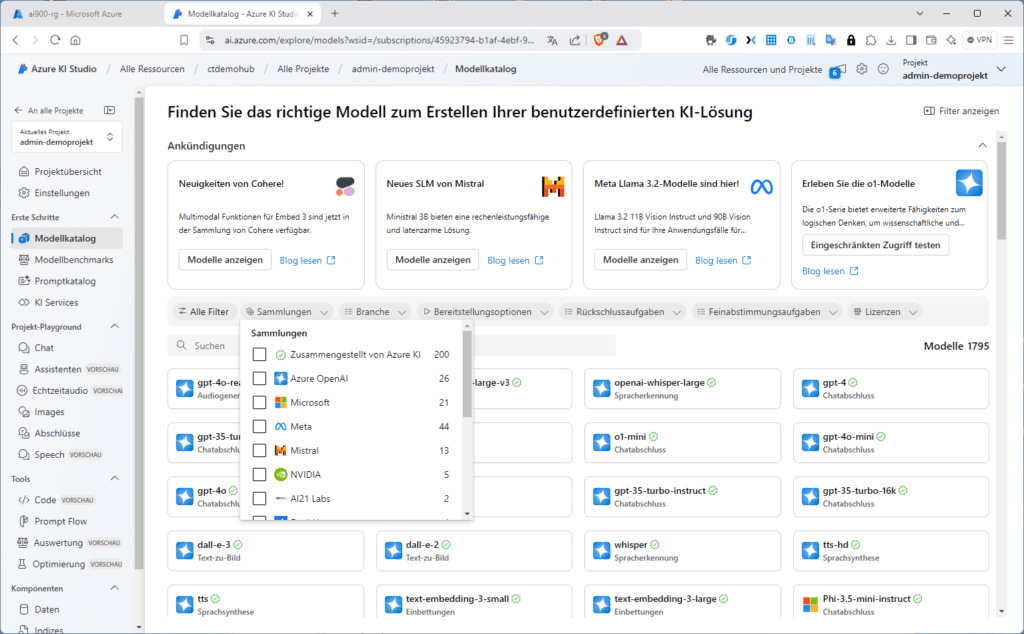

Derzeit stellt der Modellkatalog fast 1800 Modelle von Modellanbietern wie Azure OpenAI Service, Mistral, Meta, Cohere, NVIDIA und Hugging Face zur Verfügung, einschließlich Modelle, die Microsoft selbst trainiert hat. Modelle von anderen Anbietern als Microsoft, sind Nicht-Microsoft-Produkte, wie in den Microsoft-Produktbedingungen definiert und unterliegen den mit den Modellen gelieferten Geschäftsbedingungen. Im Detail gruppiert der Modellkatalog alle Modelle in Form von drei Sammlungen (Collections):

- Exklusiv in Azure verfügbare Azure OpenAI-Modelle: Hierbei handelt es sich um die Flagship-Modelle von OpenAI, welche dank der Integration des AI Studios mit Azure OpenAI Service verfügbar sind. Microsoft unterstützt diese Modelle, bzw. deren Nutzung gemäß den zugehörigen Produktbedingungen und sichert die dort aufgelisteten https://www.microsoft.com/licensing/docs/view/Service-Level-Agreements-SLA-for-Online-Services SLAs für Azure OpenAI Service zu.

- Kuratiert durch Azure AI: (Zusammengestellt von Azure KI): Hierbei handelt es sich um die beliebtesten Nicht-Microsoft-Modelle mit offener Gewichtung sowie um proprietäre Modelle, gepackt und optimiert für den nahtlosen Einsatz auf der Azure AI-Plattform. Das Verwenden dieser Modelle unterliegt den Lizenzbedingungen der jeweiligen Modellanbieter. Nutzt du Modelle dieser Kategorie in Azure KI Studio, unterliegt deren Verfügbarkeit ebenfalls der entsprechenden Azure-Vereinbarung zum Servicelevel (SLA) (siehe oben) und Microsoft bietet Unterstützung für Bereitstellungsprobleme. Modelle von Partnern wie Meta, NVIDIA oder Mistral AI dagegen kannst du in dieser Kategorie identifizieren, indem du im Katalog nach der Collection „Zusammengestellt von Azure KI“ filterst.

- Offene Modelle aus dem Hugging Face-Hub: Hier findest du hunderte von Modellen aus dem „Hugging Face-Hub“ für echtzeitbasierte Rückschlüsse mit verwalteten Compute Services. Die in dieser Sammlung aufgelisteten Modelle wurden von https://huggingface.co/ Hugging Face erstellt. Für etwaige Hilfe musst du dich in diesem Fall an das https://discuss.huggingface.co/ Hugging Face-Forum oder den https://huggingface.co/support wenden.

Azure AI Studio -Modelle bereitstellen

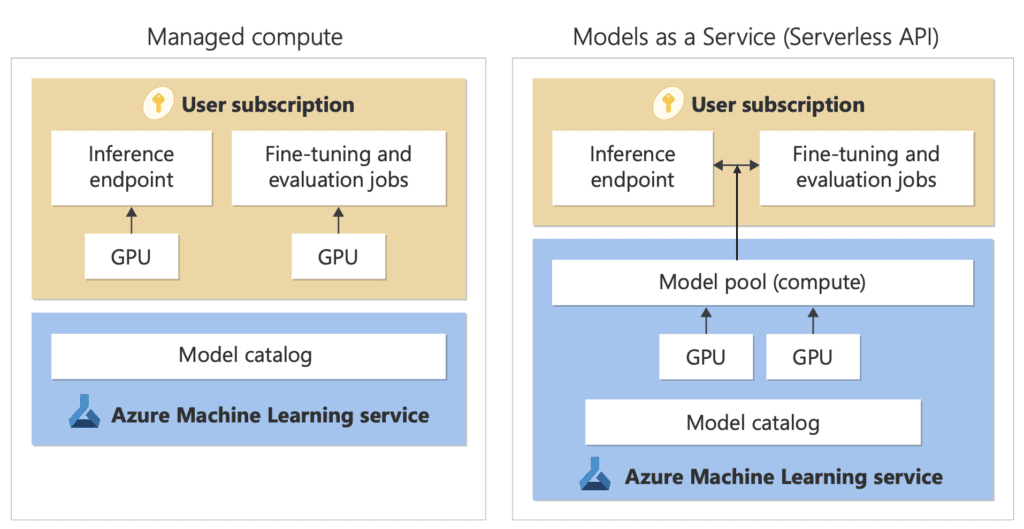

Die Optionen zur Bereitstellung des jeweiligen Modells sind modellabhängig und variieren. So kannst du einige Modelle mit der Option „verwaltete Compute Services“ bereitstellen, andere wiederrum kannst du mit Hilfe der serverlose APIs mit Abrechnung mit nutzungsbasierter Bezahlung bereitstellen. Dazu unten mehr.

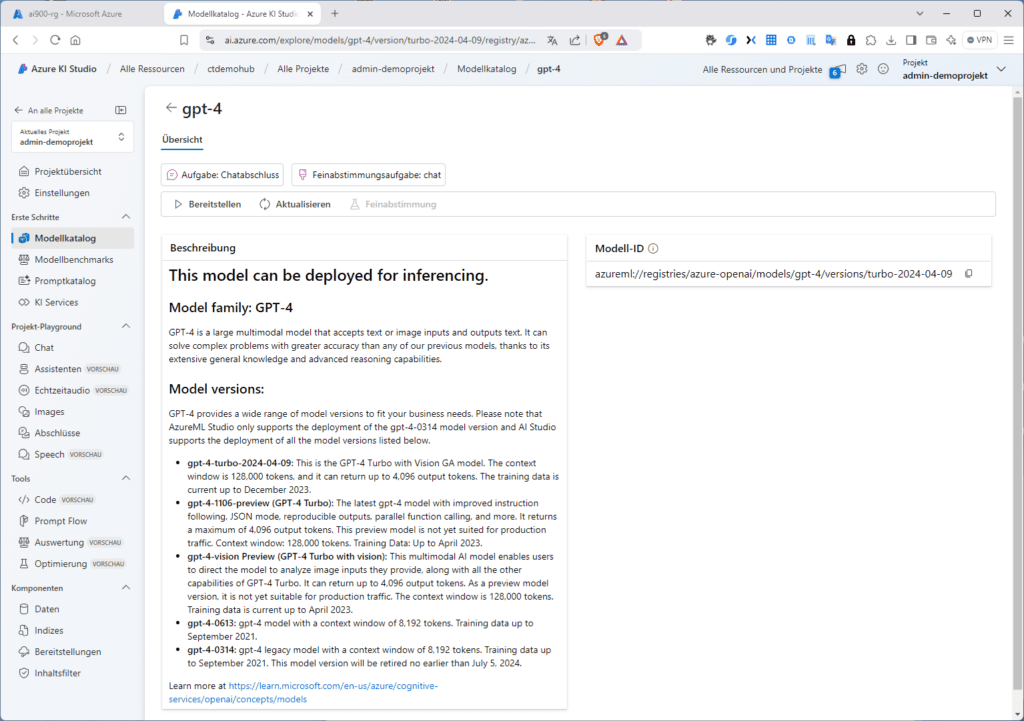

Wähle nun beispielsweise das Modell „gpt4“. Klickst du auf das Modell, findest du zunächst eine Modellbeschreibung und von hier aus die Option, das Modell bereitzustellen.

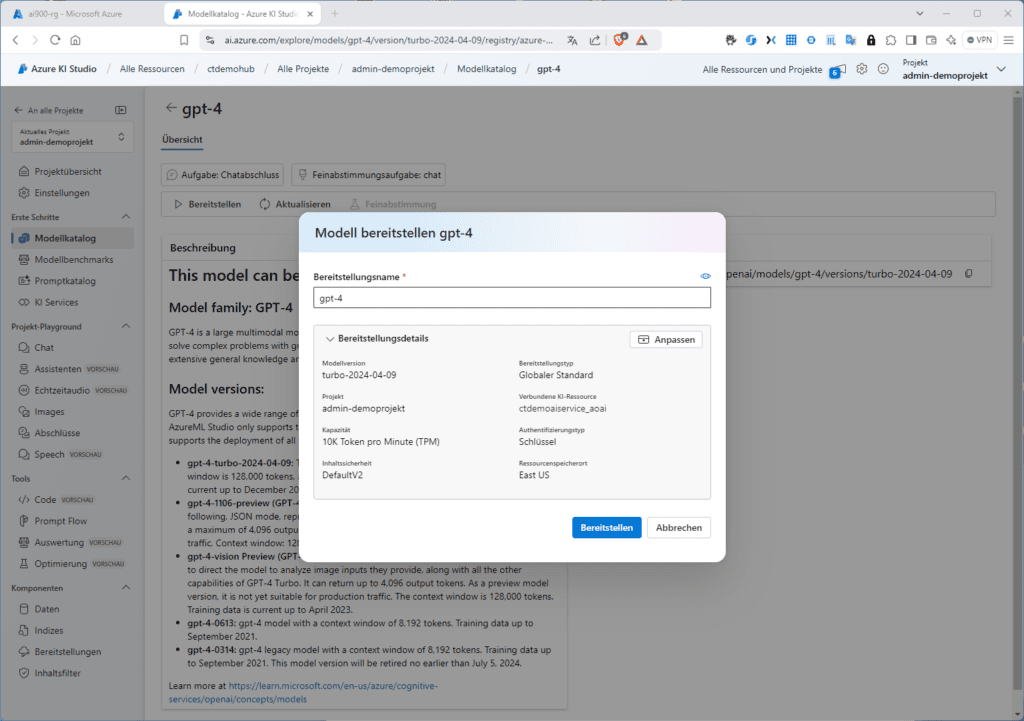

Klicke dazu einfach auf „Bereitstellen“. Den vorgeschlagenen Bereitstellungsnamen leitet das System aus dem Modellnamen ab. In der Übersicht (Bereitstellungsdetails) siehst du die spezifische Modellversion, das zugeordnete Projekt, die verbundene Azure-AI-Ressource, den Authentifizierungstyp und den Ressourcenspeicherort. Mit einem Klick auf „Anpassen“ kannst du aber weiteren Einfluss nehmen.

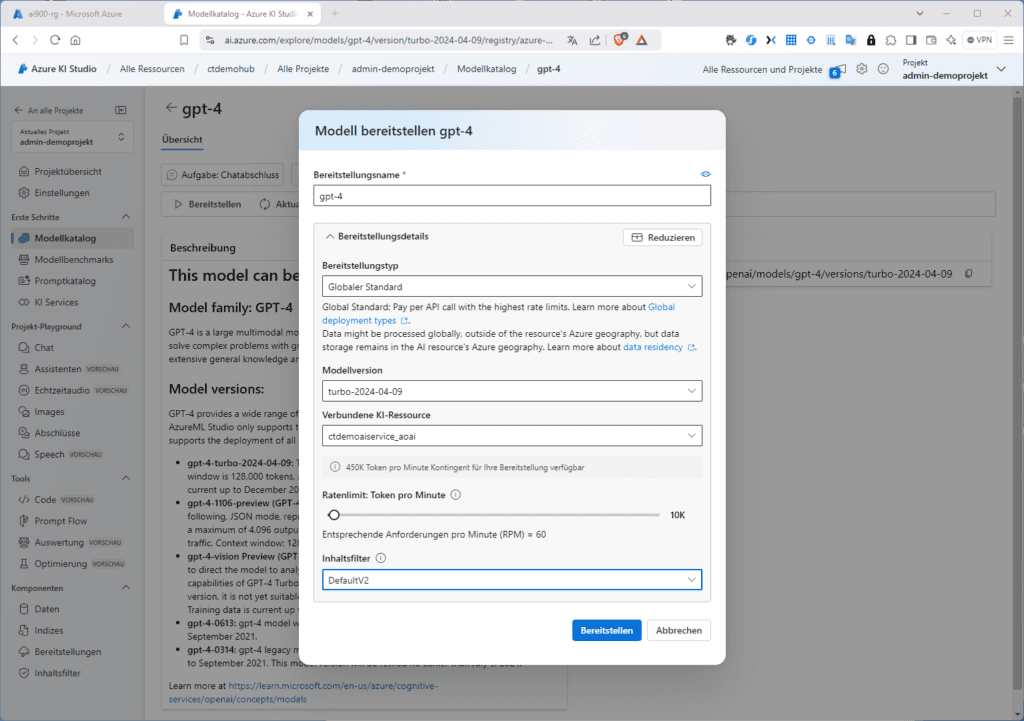

In den Anpassungen kannst du u. a. das Ratenlimit (Token pro Minute) anpassen oder den verwendeten Inhaltsfilter wählen.

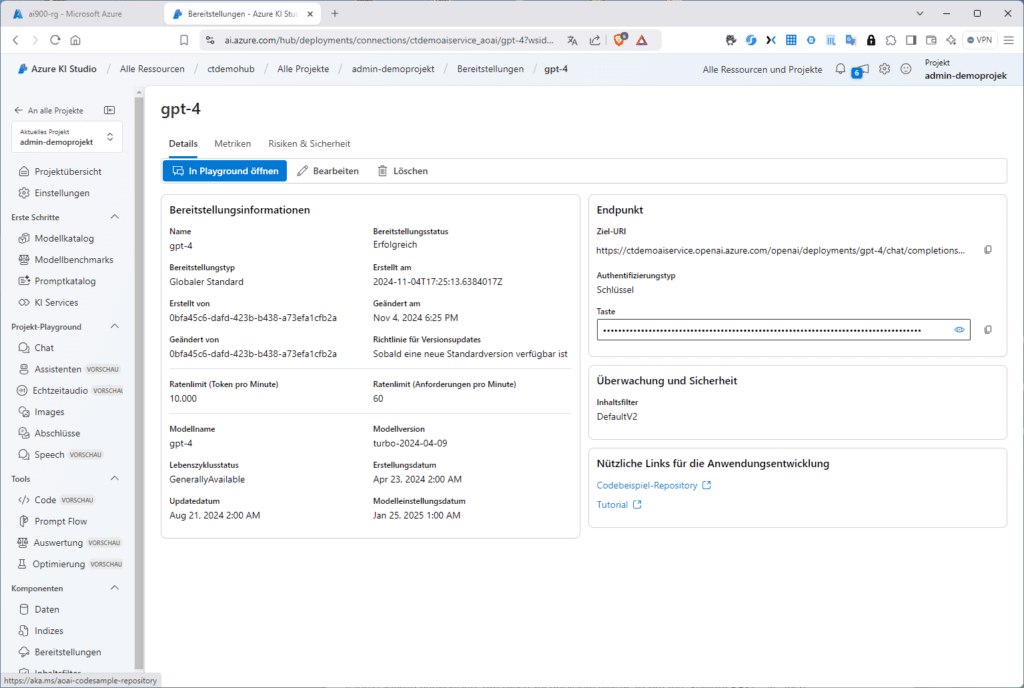

Klicke dann auf „Bereitstellen“. In der anschließend präsentierten Übersicht findest du u. a. die Ziel-URL für den Endpunkt und den Schlüssel zur programmatischen Verwendung. Ferner findest du hier auch nützliche Quick-Links u. a. zu Microsofts https://aka.ms/aoai-codesample-repository Repository mit Code-Beispielen.

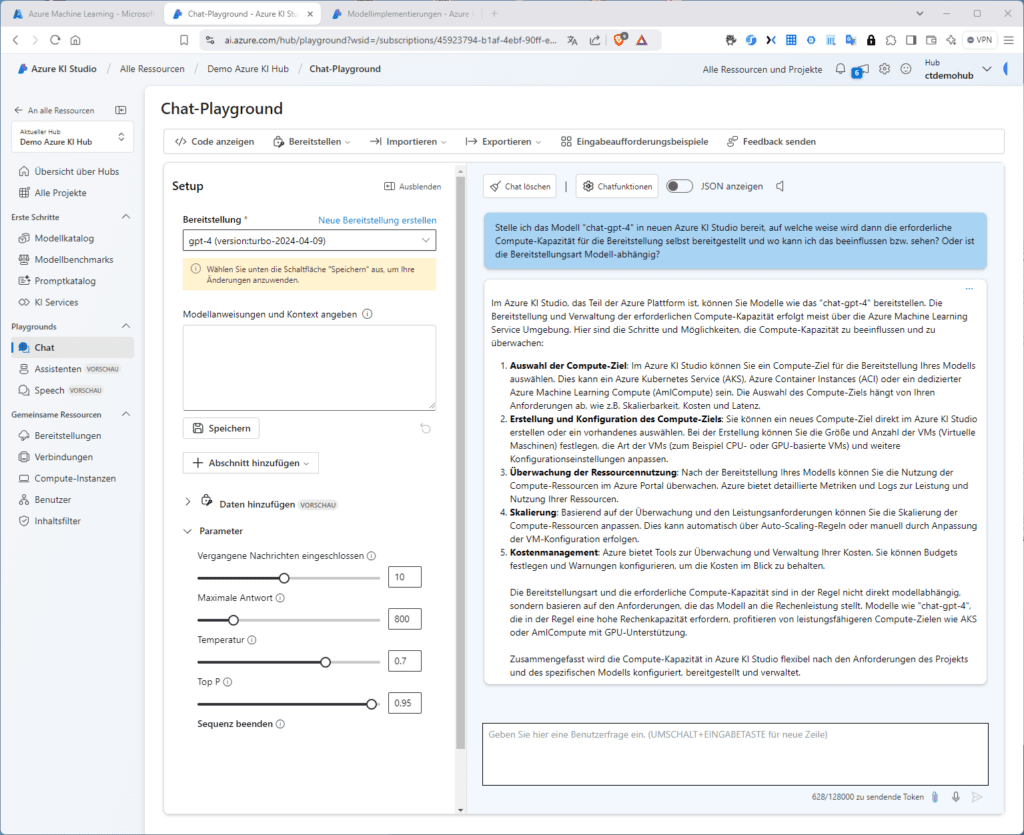

Du kannst die Leistungsfähigkeit des Modells testen, indem du auf „Im Playground öffnen“ klickst. Du kannst jetzt das Modell im Chat testen und im rechten Teil des Playground-Fensters deine Eingaben machen. Im linken Teil des Fensters (Setup) kannst du die in diesem Artikel (Link) erläuterten Modell-Parameter anpassen oder (derzeit noch Vorschau) eigene Daten hinzufügen.

Im Beispiel-Chat der Abbildung oben habe ich das KI-Modell gefragt, wie die für die Bereitstellung erforderliche Compute-Kapazität in Azure realisiert wird und ob diese Frage modellabhängig ist. In der Antwort ist die KI nicht ganz präzise. Du darfst dabei nämlich nie vergessen, dass es sich bei dieser Form generativer AI immer noch nur um ein großes Sprachmodell handelt, d. h. du musst gerade bei technischen Fragen in der Lage sein, die gelieferten Antworten einzuordnen und zu beurteilen. Wenn du es besser weist, frage weiter nach und setze das System unter Druck. So kannst du dessen Grenzen ausloten. Die Frage mit der Compute-Kapazität kannst du beispielsweise sehr einfach selbst verifizieren.

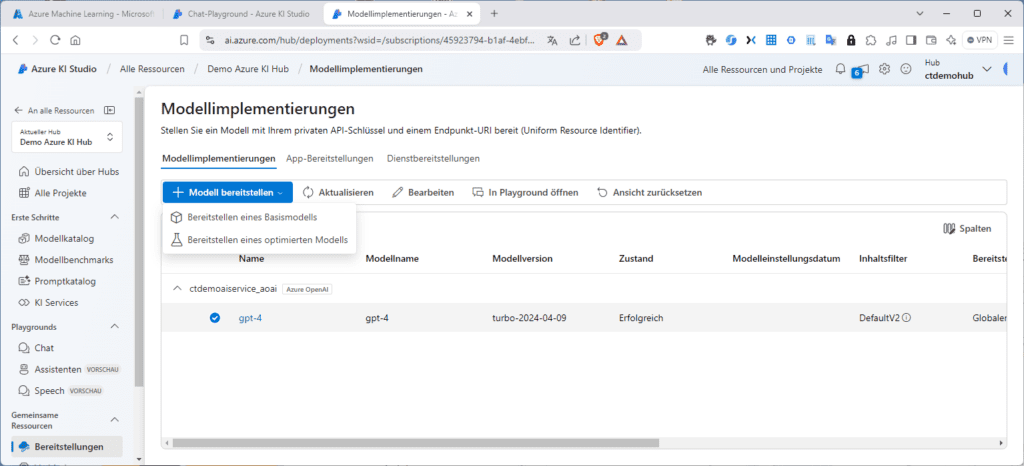

Während wir beispielsweise oben zuerst das Modell gewählt und es dann bereitgestellt haben, kannst du auch andersherum vorgehen und in das Menü „Bereitstellungen“ wechseln und von dort aus eine neue Bereitstellung starten mit einem Klick auf „Modell bereitstellen“. Hier wählst du im Klapp-Menü „Bereitstellen eines Basismodells“.

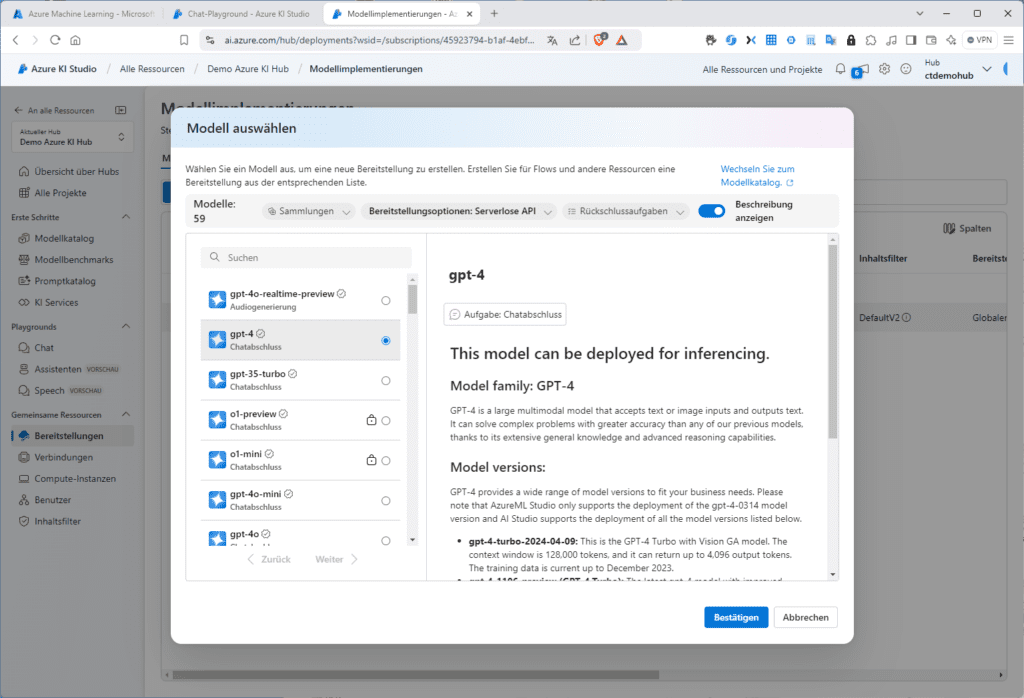

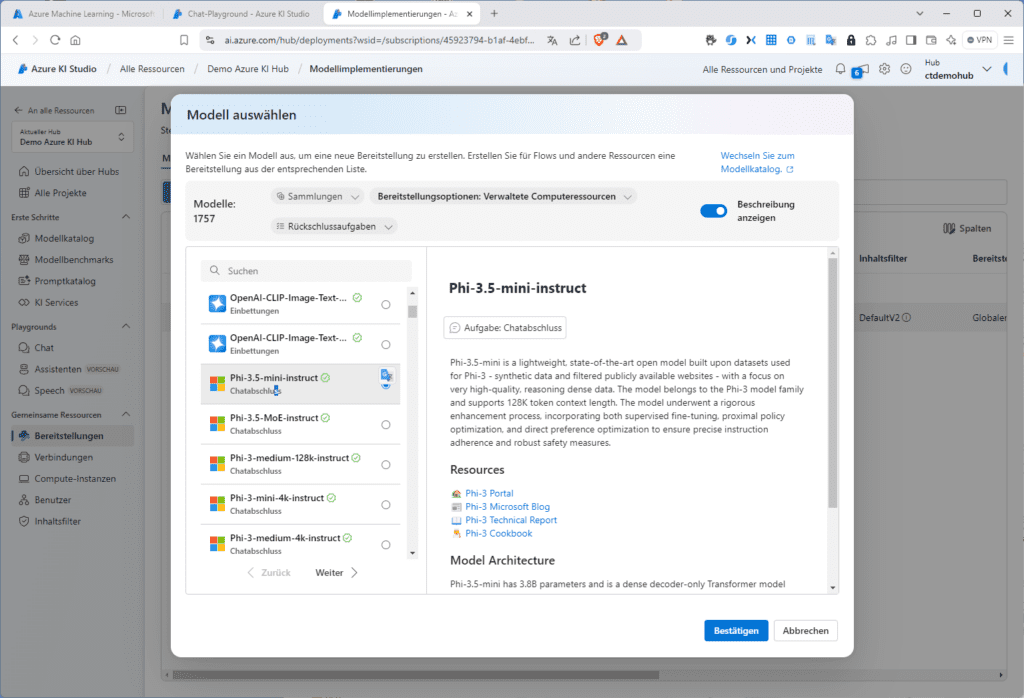

Dann wählst du aus der Modellliste mit derzeit 1795 Modellen deinen Favoriten aus (hier gpt-4).

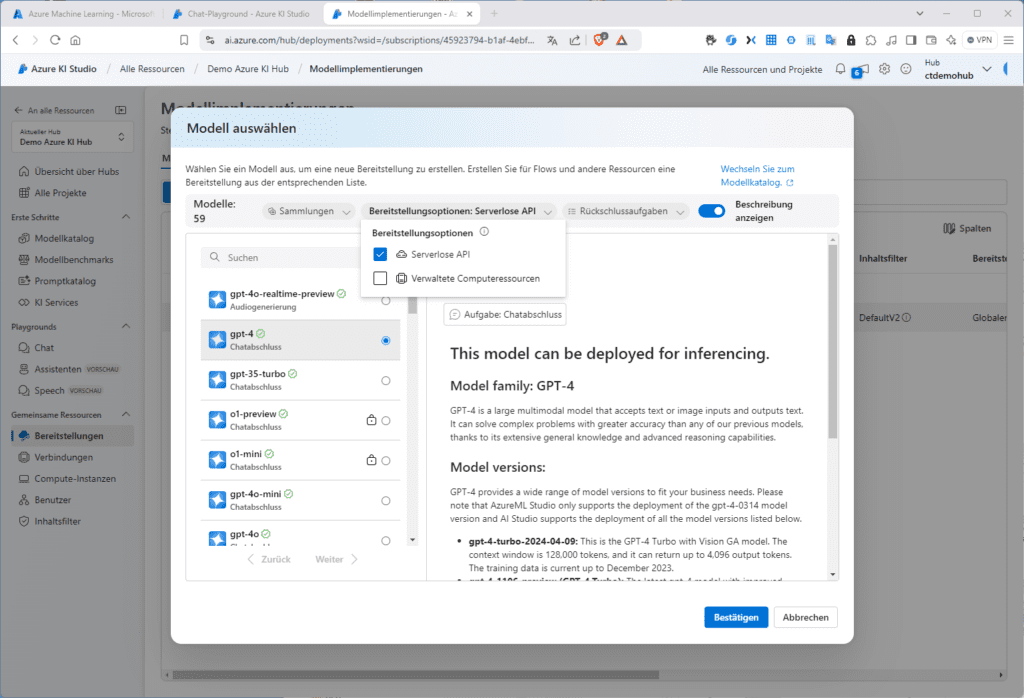

Du kannst aber auch mit Filtern arbeiten, um dir für deinen Zweck geeignete Modelle anzeigen zu lassen. Klickst du beispielsweise auf Bereitstellungsoptionen hast du die Wahl zwischen von Azure „verwaltete Computeressourcen“ und „Serverlose API“.

Auf diese Weise wird klar, dass die Chat-GPT-Basis-Modelle über die serverlose API bereitgestellt werden. Deswegen zahlst du auch nur für den Verbrauch. Filterst du hingegen nach „Verwaltete Computeressourcen“ findest du z. B. die Modelle von Mistral, Microsoft oder OpenAI.

Generative AI im neuen Azure AI Studio – Tipp:

Übrigens: Im „Azure Machine Learning-Studio“ könntest du auch Modelle auf Basis dedizierter Compute-Ressourcen bereitstellen.

Kontakt

„*“ zeigt erforderliche Felder an