Unreal Engine 4.27

Am 19. August 2021 wurde die neuste Version der Unreal Engine 4.27 von Epic Games veröffentlicht. Als letzte Hauptversion vor der vollständigen Veröffentlichung der jetzt schon im Early Access nutzbaren Unreal Engine 5 bringt diese Version mehrere Besonderheiten mit sich. Der Fokus liegt dabei ganz klar auf dem Ausbauen und Verbessern schon vorhandener Funktionalitäten und Werkzeugen für die verschiedensten Nutzungsbereiche. Aber auch einige sehr interessante Neuerungen gehen mit dieser Veröffentlichung einher.

Passende Schulungen

Unreal Engine: (Film) Level Design für Virtual Production

Unreal Engine: Entwicklung für die HoloLens 2

HoloLens 2 Anwendungsentwicklung mit Unreal Engine

Quality of Life:

Zuerst einmal kommen einige Quality of Life Verbesserungen hinzu, manche präsenter, andere fallen nicht direkt auf. Zu nennen ist hier vor allem der bessere Überblick, über die Prozesse und Ressourcenverwendung der Software.

Beim Starten eines Projekts erhielt man bisher eine kleine Prozentanzeige und recht wenig Informationen, was hinter den Kulissen eigentlich passierte. So konnte es sein, dass man bei größeren und komplexeren Projekten schon mal einige Minuten vor einem Ladebildschirm saß, der einem recht wenig über den eigentlich Ladeprozess mitteilen konnte.

In der Version 4.27 erhalten wir endlich mehr und klarere Informationen darüber, was gerade passiert.

Eine nette kleine Anzeige am oberen rechten Bildschirmrand gibt außerdem Auskunft über den Status des Derived Data Cache des aktuellen Projekts.

Virtual Production:

Natürlich gibt es auch im Bereich der virtuellen Produktion wieder einige Neuerungen. Nachdem dieser Bereich immer mehr zum Steckenpferd für die Unreal Engine wird, ist der vermehrte Fokus darauf im Bezug auf erweiterte Funktionalitäten nicht verwunderlich.

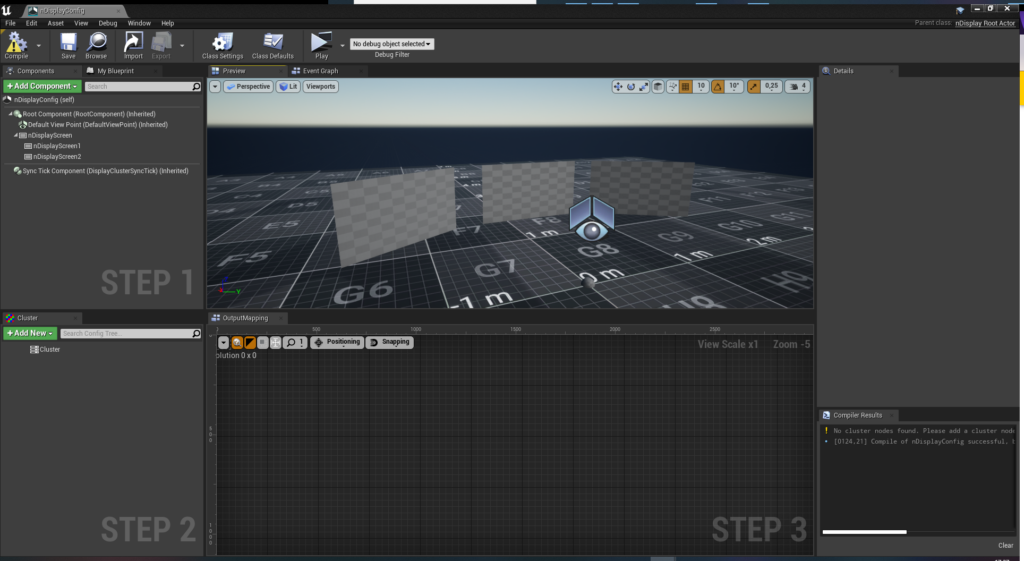

Für Multi-Screen Anwendungen steht der visuelle nDisplay Konfigurator zur Verfügung. Dort kann man in einer Art „What-you-see-is-what-you-get“-Manier Displays im 3D Raum anordnen, um diese in Relation zueinander, Perspektive und Neigung optimal an das tatsächliche Setup anzupassen.

Die Funktionalität von „mGPU“ wurde ausgebaut, die Unterstützung für mehrere Kameras und effizientere Hardwareauslastung hinzugefügt. Mit „nDisplay Overscan“ werden Nachbearbeitungseffekte wie Bllom, Ambient Occlusion und Motion Blur mit mehreren Render Nodes verwendet werden. Wo vorher ein sichtbarer visueller Schnitt war, können die verschiedenen Bildquellen nun besser zusammengefügt werden.

Eine erste experimentelle Implementierung von nDisplay Unterstützung auf Linux-Geräten und die Unterstützung von „OpenColorIO“ zur effizienteren Farbkalibrierung wurde in der 4.27 auch hinzugefügt.

Ein weiteres großes Update haben die sogenannten „Remote Control Workflows“ erhalten. Mittels eines Internetbrowsers auf einem Endgerät im gleichen Netzwerk können so mit simplen Kontrollen in Form von Buttons, Slidern, Farbrädern, usw. live Änderungen an der aktuellen Unreal Engine Szene vorgenommen werden. Ein „UI-Builder“ lässt die Konfiguration einer Kontrolloberfläche auf der aus der Szene generierten Webseite zu. Dort kann man dafür freigegebene Kontrollen hinzufügen und anordnen, um sich so ein effektives auf die aktuelle Arbeitssituation angepasste Nutzeroberfläche zu bauen. Weiterhin können auch über bekannte Protokolle wie DMX, OSC und MIDI live Einstellungen an der Szene verändert werden. Auch eine C++ API wurde dafür vorbereitetet, um über externe Desktop Applikationen Kontrollen vorzunehmen.

Die neue „Level Snapshots“ Funktion (aktuell noch in Beta) ermöglicht es, den Status einer Szene mit allen sich darin befindenen Objekten und deren Einstellungen abzuspeichern und beliebig wieder aufzurufen. Dies ermöglicht einen freieren, effizienteren und schneller iterativen Arbeitsprozess beim Einrichten einer Szene für Beleuchtung, Platzierung von Objekten und vielem mehr.

Das virtuelle Kamera-System erhielt auch weitere Verbesserungen und befindet sich nun in Produktionsreife. Die Unterstützung von mehreren Nutzern gleichzeitig, Anbindung an das interne Compositing-System „Composure“, Nutzung von individuellen UMG-Kontrollen, sind nur einige der zusätzlichen Funktionen, auf die sich die Nutzer freuen dürfen.

Die „Virtual Camera iOS App“ wurde komplett überarbeitet und ist nun mehr fokussiert auf virtuelle Kameraarbeit, als die Standard „Unreal Remote App“.

Ausgebaute Unterstützung für gängige Dateiformate

Die Nutzung des gängigen „Universal Scene Description“ (kurz USD) Dateiformats wurde ausgebaut mit einem starken Fokus auf weiteren Exportoptionen. Als eines der beliebtesten und breit genutzten Dateiformate in der Medien- und Unterhaltungsindustrie liegen nun einige zusätzliche Funktionalitäten vor, die das Arbeiten damit erleichtern und enorm verbessern. Das Exportieren von Levels und Sublevels, sowie den darin befindlichen Objekten als separate, sich gegenseitig referenzierende USD-Dateien, sowie das „Baking“ von Texturen und Materialien vor dem Export sind nur zwei von einigen Verbesserungen.

Auch die das Arbeiten mit Alembic (kurz .abc) Dateien wurde verbessert. Vor allem im Bezug auf Haar- und Fellsimulationen wurde die Verwendung das Dateiformats immer üblicher. Eine bessere Unterstützung von Alembic Cache kam auch hinzu.

Passende Schulungen

Unreal Engine: Fortgeschrittene Produktions-Workflows für Virtual Production

Datasmith

Neben einigen Verbesserungen für bereits existierende Export-Plugins für Programme wie Archicad, Sketchup, Rhino, Revit, 3DS Max und Navisworks, steht auch erstmals ein experimentelles Export-Plugin für Solidworks zur Verfügung.

Der „Visual Dataprep Workflow“ zur prozeduralen Vorbereitung von Datasmith Importen in einer modul-basierten Umgebung wurde auch verbessert und bietet nun neue Filteroptionen, Operatoren und die Unterstützung von Komponenten.

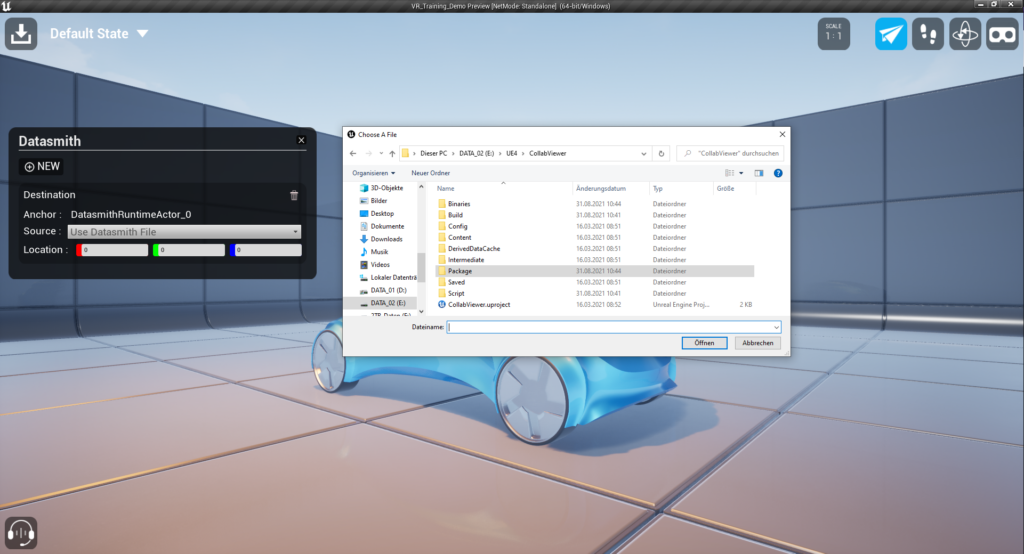

Die größte und weitreichendste Änderung im Datasmith-Bereich ist die Möglichkeit Datasmith-Dateien während der Laufzeit zu importieren. So bietet das aktualisierte Kollaborations-Template schon die Option während einer Mehrnutzer-Sitzung Datasmith-Dateien zu importieren und gemeinsam anzusehen, zu besprechen und zu bearbeiten. Dies ermöglicht vollkommen neue Anwendungsszenarien für Unreal-Engine Anwendungen, die nicht voraussetzen, dass für jedes neue Datasmith-Objekt ein Projekt noch einmal neu angepasst und kompiliert werden muss.

Ein neues Kamera-Kalibrations-Werkzeug wurde eingeführt, um Linsenverzerrungen von echten Kameras besser auf Unreal Engines Cinematic Cameras übertragen zu können.

Live Link

Im Bereich Live Link, das Echtzeit-Bewegungs-Anbindungsprotokoll der Unreal Engine, hat sich auch einiges getan. Es wird nun das „FreeD“ Datenprotokoll im Beta-Status unterstützt, welches hauptsächlich für Kameratracking von Pan, Tilt, Zoom (PTZ) Kameras verwendet wird.

Das weitere VRPN Plugin, was auch im Beta-Status erscheint, ermöglicht hingegen eine bessere Live Link Anbindung für virtuelle Realität und virtuelle Produktion.

Die Live Link Face App für iOS (für iOS Geräte mit Face-ID) ermöglicht seit der Veröffentlichung ein intuitives Verfahren für Face-Tracking. So sind auch beispielsweise die „Metahumans“ von Epic Games so vorbereitet, dass man einfach sein iOS-Gerät verbinden muss und dann die Gesichtsmimik des 3D-Charakters mit den eigenen Gesichtsbewegungen kontrollieren kann.

In der neuen Version der App kommt ein Kalibrationsmodus hinzu, der das Anpassen der übertragenen Daten an die jeweilige Person und deren Gesichtszüge anpasst. Auch die Anpassung der App, dass sie auf iPads besser nutzbar ist, ist eine willkommene Neuerung.

Sequencer

Das Sequencer Werkzeug unterstützt nun die Einzelbild-Synchronisation von Videos. Vorher war dies nur mit Bildsequenzen möglich. Nun werden aber auch Videos mit der Timeline vom Sequencer synchronisiert.

Der „Movie Render Queue“ ist nun direkt über einen Button aus dem Sequencer erreichbar und unterstützt nun außerdem Overscan und 32 Bit Farbtiefe für alle Rendervorgänge. Eine unglaublich wichtige Neuerungen für Film- und Medienschaffende, die aus der Unreal Engine exportiertes Bild-und Videomaterial in gängigen Videoschnitt- oder Bildkompositionsprogrammen weiternutzen möchten.

Die Nutzeroberfläche des Sequencers wurde zum Zweck der Nutzerfreundlichkeit weiter überarbeitet und verbessert.

Es wurde außerdem eine neue Art von Track zum Sequencer hinzugefügt, der Events in Verbindung mit dem „Gameplay Ability System“ der Unreal Engine ermöglicht.

Pixel Streaming

Die in der Version 4.21 der Unreal Engine veröffentlichte Funktion „Pixel Streaming“ ist nun mit der aktuelle 4.27 produktionsreif. „Pixel Streaming“ erlaubt es interaktive Inhalte einer Unreal Engine Applikation, die beispielsweise auf einem leistungsstarken Desktop-PC berechnet werden, via Web Browser auf einem beliebigen Endgerät (Smartphones, Tablets, schwächere Notebooks und PCs) aufzurufen. Der Vorteil besteht darin, dass das Endgerät nicht den hohen Leistungsanforderungen von anspruchsvollen Applikationen gerecht werden muss und trotzdem mit den Inhalten interagieren kann, als würden sie lokal laufen. Quasi eine Art interaktiver Videostream. Mit der Produktionsreife von „Pixel Streaming“ kann man eine Vielzahl von neuartigen Anwendungsfällen für Unreal Engine Projekte erwarten. Zusätzlich wurde auch die Unterstützung von Linux als Server Instanzen, dem AMD Encoder (AMD Advance Media Framework“, sowie grundlegende Stabilitäts und Qualitätsverbesserungen durch die Verwendung neuerer WebRTC Technologie implementiert. Dadurch wurde auch die Möglichkeit eingebaut, das Mikrofon von Nutzern im Browser abzugreifen und in der Unreal Engine Applikation zu verwenden.

Rendering

Auch im Bereich des Rendering hat sich wieder einiges getan. Die Vorberechnung von Licht- und Schatteninformationen über die Grafikkarte (statt über den Prozessor), „GPU Lightmass“ hat einiges an Zusatzfunktionen erhalten und rechnet nun um einiges genauer, realistischer und je nach Anwendungsfall noch schneller. Zwischen dem „alten“ Vorgehen das alles mit dem Prozessor zu berechnen, was meist durch die begrenzte Anzahl an Kernen bzw. Threads recht lange dauern konnte, ermöglicht „GPU Lightmass“ einen viel bequemeren, iterativen und schnelleren Arbeitsablauf.

Der „Path Tracer“ (aktuell noch im Beta-Stadium) geht einen ganz anderen Weg als alle sonst doch hauptsächlich auf Echtzeit-Bildberechnung ausgelegte Funktionen der Unreal Engine und funktioniert ähnlich wie eine klassische Render-Pipeline. Mit NVIDIA Raytracing fähigen Grafikkarten und DirectX 12 können Bilder erzeugt werden, die eine vollumfängliche und physikalisch korrekte Licht- und Schattenberechnung, korrekte Reflexionen und Refraktionen enthalten. Mittels Sample-Zahlen, Anzahl der Lichtberechnungen und einer eingebauten Rauschentfernung, die man über das Post-Process-Volume steuern kann man so den höchsten Grad an Realismus erreichen. Natürlich auf Kosten der Echtzeit-Berechnung.

Mit der Einführung des „MetaHuman Creator“ in der Version 4.26 wurden viele Verbesserungen im Bereich Haar- und Felldarstellung für die Version 4.27 eingeführt, um diese noch realistischer zu gestalten.

VR / AR / XR

OpenXR ist in der Version 4.27 endlich produktionsreif und ermöglicht die simplere Programmierung von VR, AR und XR Applikationen für verschiedene Plattformen, durch einen umfassenden Standard. Mit dazu gibt es ein komplett überarbeitetes VR-Template Projekt, welches extra mit OpenXR aufgesetzt und dafür optimiert ist.

Auch das Augmented Reality Template wurde überarbeitet und bringt nun mehr Funktionen mit, auf denen man aufbauen kann. So kann man nicht mehr nur Objekte platzieren, sondern auch verschieben, drehen und skalieren. Eine grundlegende Nutzeroberfläche und die Möglichkeit Schnappschüsse abzuspeichern sind auch mit dabei. Das Template funktioniert automatisch mit beiden gängigen AR-Plattformen ARCore (Android) und ARKit (iOS).

Niagara

Das prozedurale und modul- sowie node-basierte Werkzeug für Partikelsimulationen „Niagara“ hat auch einen Schwung neue Funktionen spendiert bekommen.

Module, Funktionen und dynamische Inputs lassen sich nun versionieren. So kann man Einstellungen und Änderungen an beispielsweise Modulen speichern und dann in einem iterativen Prozess mehrere Versionen ausprobieren und die beste benutzen.

Beim Erstellen eines neuen „Niagara“-Systems stehen nun zusätzlich Beispiele für Partikelverhalten zur Verfügung. Auf Basis dieser vorgefertigten Partikelsysteme kann man einerseits die Funktionalität erforschen und auch eigene komplexe Systeme bauen.

Der neue „Niagara-Debugger“ gibt eine bessere und klarere Übersicht über Performance und Simulationsstatus von Partikelsystemen.

Für Partikelsysteme mit 3D-Objekten als Partikel können nun Arrays von 3D-Objekten genutzt werden. So kann ein Partikelsystem mehrere unterschiedliche 3D-Objekte als Partikel verwenden und diese entweder zufällig oder in Reihenfolge anzeigen.

Fazit

Die Unreal Engine entwickelt sich stetig weiter in so viele verschiedene Richtungen, dass man das Programm eigentlich kaum noch nur als „Game-Engine“ bezeichnen kann. So viele andere Anwendungsszenarien sind möglich und werden auch offensichtlich von Epic Games unterstützt und gefördert. Gerade entwicklerfreundliche Funktionen, wie die klarere Anzeige welche Prozesse beim Laden von Projekt im Hintergrund ablaufen, zeigen, dass der Fokus auf Nutzerfreundlichkeit bei all dem Funktionsumfang nie verloren gehen soll.

Für einen umfassenden Überblick über alle neuen Funktionen kann man nur die Release Notes der Unreal Engine empfehlen:

https://docs.unrealengine.com/4.27/en-US/WhatsNew/Builds/ReleaseNotes/4_27/

Kontakt

„*“ zeigt erforderliche Felder an